Robots.txt یک فایل راهنما برای ربات های خزنده موتور های جستجو می باشد.

با یک مثال این موضوع به راحتی توضیح خواهیم داد, فرض کنید که به شهری رفته اید که برای اولین بار است که به آن سفر کرده اید, شما با این شهر کاملا ناآشنا هستید, برای این که بتوانید به راحتی خیابان ها و مناطق را سیر کنید از اپلیکیشن هایی که خدمات نقشه ارائه می دهند (مانند گوگل مپ, نشان, بلد و …) می توانید استفاده کنید, این ابزار ها قادر هستند زمان, مسافت, طرح های ترافیک, خیابان های یک طرفه, پر ترافیک و … را به شما نشان بدهند و سفر را برای شما آسان کنند. در واقع این ابزار ها به شکلی شما را راهنمایی میکنند که از بهترین مسیر ها و نقاط آگاهی پیدا کنید و از آنها استفاده کنید و از سمت دیگر شما را از بخش هایی که ممکن است زمان شما را تلف کند دور میکند.

فایل Robots.txt یک فایل راهنما برای ربات های خزنده موتور های جستجو هستند که برای بررسی صفحات و مطالب جدید به سایت مراجعه میکنند (اشتباه نکنید این فایل برای کاربران عادی کارایی ندارد), با استفاده از این فایل می توان به ربات ها فهماند که می توانند چه دایرکتوری ها, لینک ها و فایل های را بررسی کنند و چه چیزی را بررسی نکنند. چرا که این ربات ها مطالب درون سایت ها را جمع آوری میکنند و در سرور های خود ذخیره میکنند و ممکن است لینک ها یا فایل های وجود داشته باشد که ما نمی خواهیم که کسی از آنها مطلع شود و در صورتی که ربات ها را کنترل نکنیم به تمام بخش های خواسته و ناخواسته سایت سرک خواهند کشید و هرچیزی را که بدست بیاورند ذخیره میکنند, و به راحتی با استفاده از دستوراتی که در این فایل می توانیم بنویسیم, خواسته های خود را به ربات ها می فهمانیم.

Robots.txt چیست ؟

در واقع اگر بخواهیم مفاهیم بالا را جمع بندی کنیم میتوانیم بگوییم که با استفاده از فایل Robots.txt می توان مجوز های دسترسی به دایرکتوری ها, فایل ها و لینک های یک سایت را تنظیم کرد تا ربات هایی که به سایت به هر دلیلی سر میزنند, اجازه داده نشود تا به هر بخشی سرک بکشند.

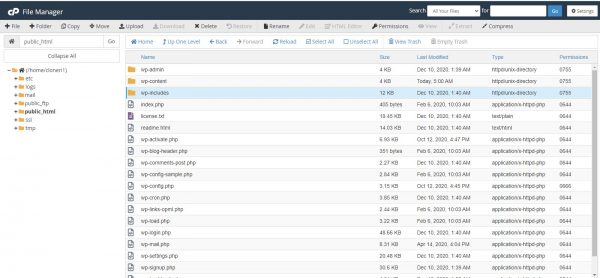

محل قرارگیری فایل Robots.txt

برای مطالعه این فایل در سایت خود یا دیگر سایت ها می توانید از لینک مشابه https://7cloner.com/robots.txt استفاده کنید و اگر قصد دارید که این فایل را خودتان ویرایش کنید به راحتی می توانید به روت هاست خود (درون فولدر public_html یا www) مراجعه کنید.

اگر نتوانستید این فایل را در روت هاست خود نیز پیدا کنید باید بدانید که بیشتر سیستم های مدیریت محتوا یک فایل مجازی با این نام ایجاد میکنند که بتوانند دسترسی کامل بر روی آن را داشته باشند که بتواند در شرایط مختلف تغییرات را سریعتر اعمال کند. در صورتی که تمایل داشته باشید می توانید خودتان یک فایل با این نام بسازید.

ضرورت های استفاده از فایل Robots.txt

1. کنترل ترافیک مصرفی ربات ها

به دلیل اینکه پهنای باند قابل استفاده برای برخی از سایت ها کم می باشد و به سرعت به اتمام می رسد و از سوی دیگر ممکن است سیستم درگیر پردازش های زیاد ربات ها شود, پس بهتر است برای کاهش این موارد ربات ها را کنترل کنیم.

2. کنترل عدم نمایش فایل ها و لینک های خصوصی

به این دلیل که قوانین ثابتی برای عدم بررسی برخی موارد در ربات ها وجود ندارد, این ربات ها در صورتی که این فایل وجود نداشته باشد یا به درستی طراحی نشده باشد, به هر بخشی که بتواند سرک می کشد و هرچیزی را که فکرش را بکند را بررسی و در دیتابیس خود ذخیره میکند تا در نتایج جستجو به نمایش بگذارد.

3. عدم دریافت نمره منفی در سئو

هرچقدر تعداد صفحات سایت شما بیشتر باشد, بررسی سایت شما توسط ربات های خزنده نیز طولانی می شود و همین طولانی بودن بررسی ممکن باعث ایجاد نمره منفی به سایت شما شود. این ربات ها دارای ویژگی به نام Crawl Budget (بزودی در مقاله ای دیگر به آن خواهیم پرداخت) می باشند که به این موضوع اشاره دارد.

دستورات Robots.txt

برای استفاده از این دستورات باید ابتدا عنوان آن را در اول خط وارد کنید سپس دو نقطه روی هم (:) را رو به روی آن قرار دهید و مقدار مورد نظر را وارد کنید.

در پایین چهار نوع از مهمترین دستورات پر کاربر این فایل را گفته ایم :

1. User-agent : مشخص کردن ربات یا ربات هایی که دستورات برای آن نوشته شده اند (برخی از ربات ها دستورات خاص خود را دارند). برای این بخش اگر بخواهید همه ی ربات ها را مجاز کنید می توانید از * استفاده کنید و اگر بخواهید یک ربات را هدف قرار دهید کافیست نام آن را بنویسید.

نمونه :

User-agent : * //OR User-agent : Googlebot

2. Disallow : بخش هایی که ربات ها اجازه دسترسی و بررسی آن ها را ندارند. در این بخش هم اگر بخواهید مسیری را برای ربات ها مشخص کنید که به آن دسترسی نداشته باشد باید ایتدا بک اسلش (/) قرار دهید و سپس آدرس مسیر را مشخص کنید, به این نکته توجه کنید که اگر تنها از اسلش استفاده کنید دسترسی به تمام دایرکتوری ها و لینک را مسدود میکنید و اگر خالی بگذارد دسترسی به تمام بخش ها را آزاد میکنید.

3. Allow : بخش هایی که ربات ها مجاز به بررسی و دسترسی به آن ها هستند. نوع استفاده برای این آیتم کاملا مشابه Disallow می باشد.

4. Sitemap : در این بخش لینک نقشه سایت قرار میگرد که یکی از راه ها برای شناساندن نقشه سایت به ربات ها می باشد ( برای شناساندن نقشه سایت بهتر است از گوگل کنسول اقدام کنید). برای نمونه :

Sitemap : https://7cloner.com/robots.txt

نحوه تست فایل Robots.txt

برای تست این فایل می توانید از ابزار تست کننده گوگل مستر از این لینک استفاده کنید (قبل از تست از وجود این فایل در آدرس گفته شده اطمینان حاصل کنید).

در صفحه بالا به راحتی می توانید دامنه هایی که قبلا در گوگل کنسول اضافه کرده اید را مشاهده کنید اگر هم نه می توانید سایت خود را اضافه کنید. بعد از انتخاب دامنه مورد نظر به صفحه ای دیگر هدایت میشود که آخرین محتوای فایل Robots.txt که توسط ربات ها خوانده شده است را به شما نمایش میدهد در صورت نیاز می توانید موارد را دستی ویرایش کنید و سر آخر دکمه submit را بزنید.

در صفحه جدید می توانید فایل ویرایش شده را دانلود کنید و آن را روت هاست خود آپلود کنید (این آپلود اگر نمی خواهید فایل را ویرایش کنید زیاد مهم نیست) و سر آخر دکمه submit را فشار بدهید تا مجدد محتوای فایل را فراخوانی کند و محتوای جدید را به شما نمایش بدهد.

اگر هم نیاز دارید که یک لینک خاصی را توسط یکی از ربات های گوگل تست کنید می توانید در نوار پایین آن آدرس خود را وارد کنید و ربات مورد نظر خود را انتخاب کنید و دکمه test را بزنید تا تست شروع شود.

نکات مهم امنیتی

در استفاده از این فایل باید نهایت دقت را داشته باشید, در پایین دو نکته را بیان کرده ایم که باید به آن ها توجه کنید و حتما در صدد رفع آنها اقدام کنید.

- بسیاری از آدرس های را که در فایل Robots.txt آنها را Disallow میکنیم میتوانند مجدد توسط ربات ها ایندکس شوند, این روند به دلیل نیست که Disallow در فایل Robots.txt نادیده گرفته میشود, بلکه ممکن است در صفحات خود به برخی از این آدرس های لینک داده باشیم و ربات ها این لینک ها را دنبال میکنند و صفحه مورد نظر بررسی و سرآخر ایندکس میشود. برای حل این مسله سه راه کلی وجود دارد, اول از برنامه نویس خود بخواهید که مجوز های دسترسی به تمام صفحات مهم را به گونه ای طراحی کند که هر شخصی قابلیت دسترسی به آن را نداشته باشد, دوم اینکه از این لینک ها در صفحات عمومی و مجاز برای بررسی خود استفاده نکنید, سوم این که مجددا از برنامه نویس خود بخواهید که در این گونه صفحات از تگ زیر در head صفحات استفاده کند :

<head>

<meta name="robots" content="noindex"/>

</head>

- ربات های مختلفی برای کار های مختلف طراحی شده اند که ممکن است به سایت ما سر بزنند و صفحات را مورد بررسی قرار بدهند, نکته ی مهمی که باید در نظر داشته باشید این است که دستورات برای همه ربات ها یکی نیست و هر رباتی ممکن است دستورات خاص خود را داشته باشد که باید دستورعمل های آن ربات را مطالعه کنید و این فایل را بر آن اساس سفارشی سازی کنید.